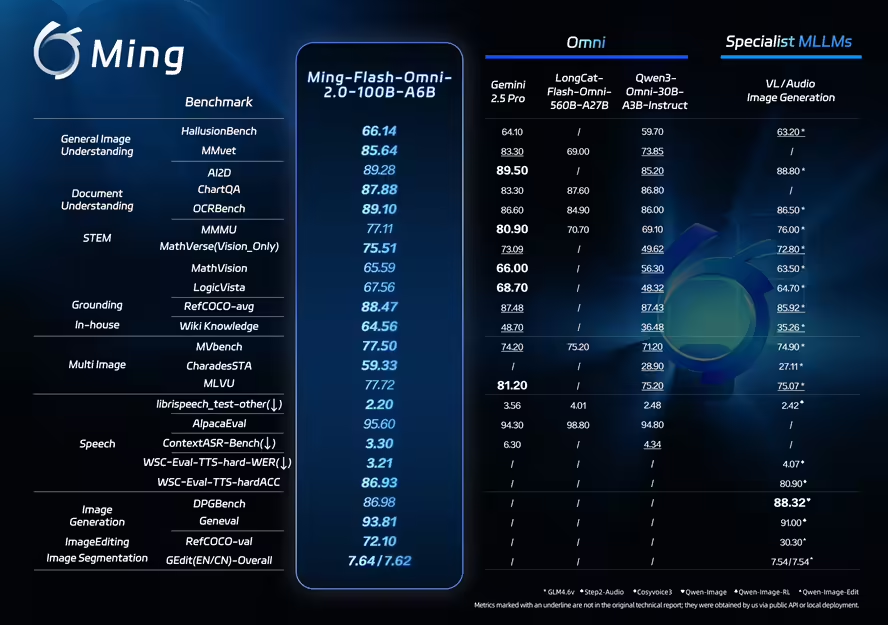

11 февруари — Ant Group официално отвори своя голям модел с пълна модалност, Ming-Flash-Omni 2.0, който демонстрира силна производителност в множество публични показатели в разбирането на езика на визуализацията, генерирането на контролируема реч и генерирането и редактирането на изображения.

Според компанията, Ming-Flash-Omni 2.0 е първият в индустрията унифициран модел за генериране на аудио на пълна сцена, способен да генерира реч, звукови ефекти от околната среда и музика в рамките на един аудио запис. Потребителите могат да издават подкани на естествен език, за да контролират точно тембъра на гласа, скоростта на говора, тона, силата на звука, емоцията и диалекта.

По време на извод моделът постига ултра-ниска честота на кадрите от 3,1 Hz, което позволява генериране на аудио с висока точност в реално време с продължителност от минута, като същевременно поддържа водеща ефективност и ефективност на разходите.

Наблюдателите от индустрията широко вярват, че мултимодалните модели в крайна сметка ще се сближат към унифицирани архитектури, които позволяват по-дълбока координация между модалностите и задачите. Въпреки това, така наречените системи с „пълна модалност“ често се борят да балансират генерализацията и специализацията, като моделите с отворен код обикновено не се представят по-слабо от аналози за специфични задачи в нишови области.

Ant Group инвестира в пълномодални изследвания на AI от години. Серията Ming-Omni еволюира прогресивно: ранните версии създадоха унифицирана мултимодална основа, итерациите на средния етап потвърдиха предимствата на мащабирането, а най-новата версия 2.0 използва по-големи набори от данни и систематични оптимизации за обучение, за да издигне пълното разбиране на модалността и генерирането до водещо ниво с отворен код — надминавайки най-добрите специализирани модели в определени области.

Чрез отварянето на Ming-Flash-Omni 2.0, Ant пуска основните си възможности като основа за многократна употреба, предоставяйки на разработчиците унифицирана входна точка за разработка на мултимодални приложения от край до край.

Моделът е изграден върху архитектурата Ling-2.0 (MoE, 100B-A6B) и е оптимизиран около три цели: по-остро зрение, по-фин слух и по-стабилно генериране.

- Визия: Включва стотици милиони фини извадки от данни и трудни стратегии за обучение, като значително подобрява разпознаването на тясно свързани видове, сложни детайли на изработка и редки културни артефакти.

- Аудио: Позволява унифициран говор, звуков ефект и генериране на музика в рамките на една песен, поддържа фино контрол на естествения език на гласовите параметри и предлага клониране и персонализиране на глас с нула удари.

- Изображение: Подобрява стабилността при сложни задачи за редактиране, поддържайки настройки на осветлението, подмяна на сцена, оптимизиране на поза и ретуширане с едно щракване, като същевременно запазва визуална последователност в динамични сценарии.

Zhou Jun, ръководител на моделния екип на Ling, каза, че ядрото на технологията за пълна модалност се крие в постигането на дълбока интеграция и ефективна оркестрация на мултимодални възможности чрез унифицирана архитектура. След изданието с отворен код, разработчиците могат да използват повторно визия, реч и възможности за генериране в рамките на една рамка, значително намалявайки сложността и разходите за свързване на множество модели.

Гледайки напред, екипът планира допълнително да подобри времевото разбиране на видеото, сложното редактиране на изображения и генерирането на дълго аудио в реално време, като същевременно усъвършенства инструментите и системите за оценка, за да ускори широкомащабното търговско внедряване.

Теглата на модела и кодът за извод за Ming-Flash-Omni 2.0 вече са налични на Hugging Face и други платформи с отворен код. Потребителите могат също да тестват модела чрез платформата Ling Studio на Ant.

Източник: IT Home

Source link

Like this:

Like Loading…

Нашия източник е Българо-Китайска Търговско-промишлена палaта